Исследователи ИИ компании Meta сегодня объявили о нескольких ключевых разработках, связанных с адаптивной координацией навыков и репликацией зрительной коры, которые позволят роботам с ИИ автономно функционировать в реальном мире.

Эти разработки являются крупным шагом вперёд в создании универсального «воплощённого ИИ», способного взаимодействовать с реальным миром без вмешательства человека.

Зрительная кора — область мозга, которая позволяет организмам использовать зрение для совершения действий. Таким образом, искусственная зрительная кора является ключевым требованием для любого робота, которому необходимо выполнять задачи на основе того, что он видит перед собой.

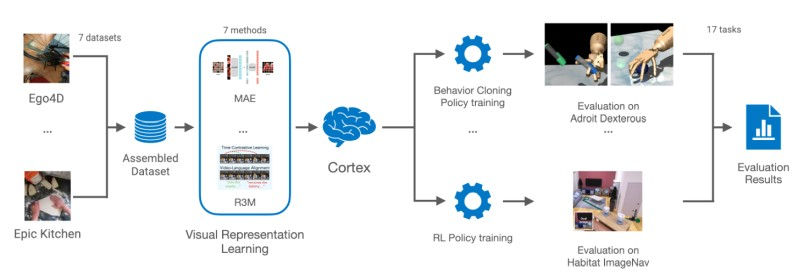

Искусственная зрительная кора VC-1 обучена на наборе данных Ego4D, который содержит тысячи часов видео с носимых камер участников исследования по всему миру, выполняющих повседневные действия, такие как приготовление пищи, уборка, спорт и ремесла.

Однако зрительная кора — это лишь один из элементов воплощённого ИИ. Чтобы робот мог работать полностью автономно в реальном мире, он должен быть способен манипулировать объектами реального мира — перемещаться к объекту, поднимать его, переносить в другое место и размещать объект — и делать все это на основе того, что он видит и слышит.

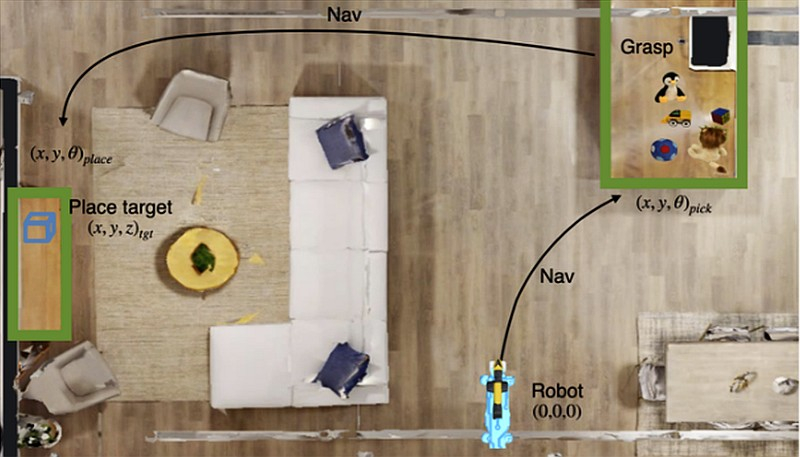

Чтобы решить эту проблему, эксперты по ИИ Meta в сотрудничестве с исследователями из Технологического института Джорджии разработали новую технологию ASC (Adaptive Skill Coordination — Адаптивная координация навыков), где обучение происходит в симуляциях, а затем эти навыки передаются реальному роботу. Meta* продемонстрировала эффективность ASC в сотрудничестве с Boston Dynamics. ASC была интегрирована с робопсом Spot, который обладает надёжными возможностями распознавания, навигации и манипулирования, хотя и требует значительного вмешательства человека.

Исследователи ставили перед собой цель создать модель ИИ, которая сможет воспринимать мир с помощью бортовых датчиков через API Boston Dynamics. Сначала ASC была обучена в симуляторе Habitat с использованием наборов данных HM3D и ReplicaCAD, содержащих 3D-модели более тысячи домов. Затем виртуального робота Spot научили передвигаться по незнакомому дому, подбирать предметы, переносить их и класть в нужное место.

Позже эти знания были переданы реальным роботам Spot, которые автоматически выполняли те же задачи, основываясь на полученном представлении о помещениях.

«Мы использовали две совершенно разные среды реального мира, в которых Spot попросили переставить различные объекты — полностью меблированную квартиру площадью 185 м² и университетскую лабораторию площадью 65 м². — Сообщают исследователи. — ASC добилась почти идеальной производительности, преуспев в 59 из 60 эпизодов, преодолев аппаратные нестабильности, сбои выбора и состязательные помехи, такие как движущиеся препятствия или заблокированные пути».

Исследователи Meta сегодня открывают исходный код модели VC-1, делясь подробными сведениями о масштабировании модели и размерах наборов данных. Следующей целью команды будет попытка интегрировать VC-1 с ASC, чтобы создать единую систему, которая станет ближе к истинному воплощённому ИИ.